- MobileNetv2:

适用于移动端部署或者对分割预测速度有较高要求的场景,PaddleSeg 还提供从 0.5x 到 2.0x 不同 DepthMultiplier 的模型。

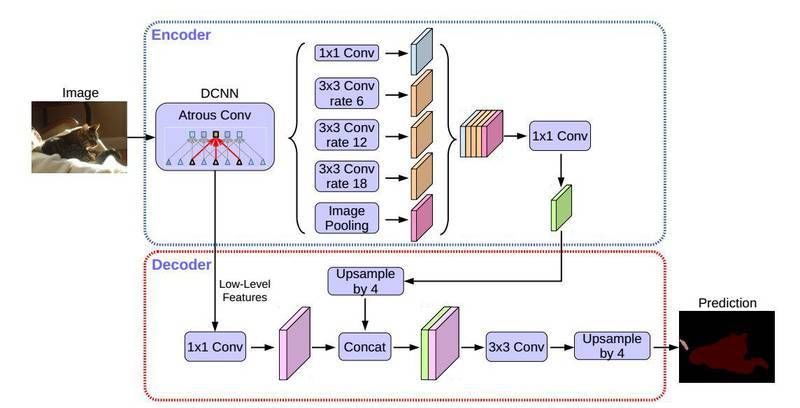

- Xception:

DeepLabv3+原始实现的 backbone 网络,兼顾了精度和性能,适用于服务端部署。PaddleSeg 提供了 41/65/71 三种不同深度的预训练模型。

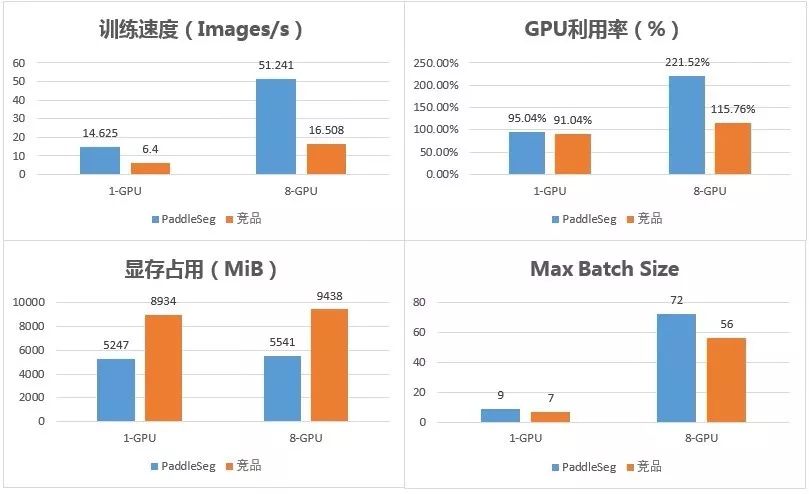

- GPU: Nvidia Tesla V100 16G * 8

- CPU: Intel(R) Xeon(R) Gold 6148

- Model: DeepLabv3+ with Xception65 backbone

- 高性能 C++预测库:

支持 Windows 跨平台兼容,支持 Operator 算子融合、TensorRT 加速、MKL-DNN 等计算图优化。

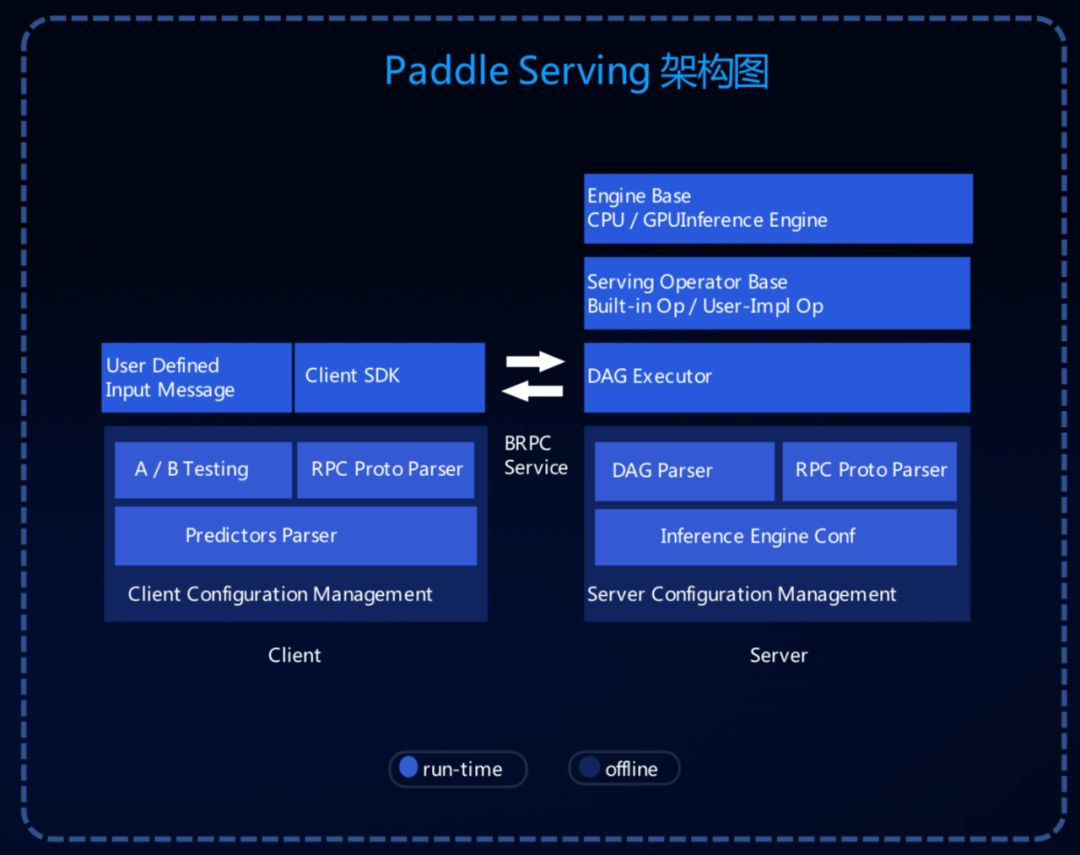

- Paddle Serving 服务化部署:

支持高并发预测,支持单服务多模型,还支持模型热更新和 A/B Test。

津公网安备12011002023007号

津公网安备12011002023007号