在ChatGPT月活飙升至10亿里程碑之际,OpenAI创始人Sam Altman的“全球巡回”同样备受关注。

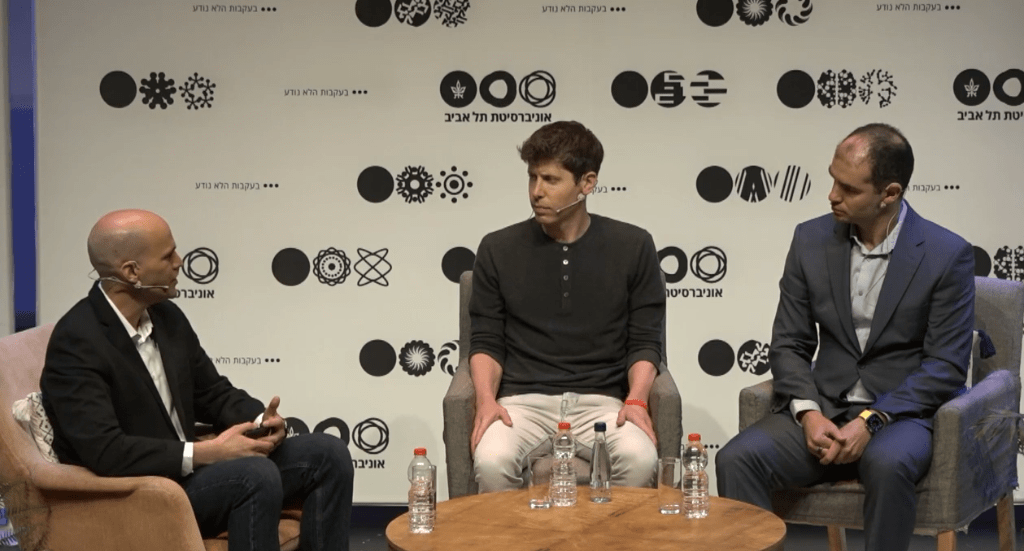

本周,Sam Altman来到以色列特拉维夫大学,与在以色列长大的OpenAI首席科学家Ilya Sutskavel共同展开了一场生动且深刻的访谈(两人甚少同台),在场观众的提问内容也颇为专业,甚至Sam都被问得一时语塞,值得一听。

核心观点:

1、OpenAI的优势所在:我们更专注于我们所做的事情,我们的文化注重严谨和可重复创新。

2、学术界在AI领域的地位:学术界曾经是AI研究的前沿,但由于较弱的计算能力和缺乏工程文化,这种情况发生了变化。但是学术界依然能对AI做出重要贡献,可以从我们正在训练的神经网络中解开许多谜团。

3、开源OR不开源:我们开源了一些模型,并计划开源更多模型,但不认为把一切模型开源是正确的策略,我们正在努力寻找平衡。

4、AI不容忽视的风险:工作岗位受到影响、黑客获得超级智能和系统失控是AI令人担忧的三大风险。AI可以发挥惊人的作用,但也可能造成糟糕的影响,因此我们合适的监管架构来控制这项技术的使用,比如建立全球性机构。

5、AI会加速科学发现吗:AI或许能帮助人类完成一些目前无法实现的科学目标,比如促进医疗健康发展、缓解气候变化难题甚至探索宇宙的奥秘,这是Sam认为AI令人最兴奋的事情。

整个访谈不乏深度,同时也不缺趣味。

比如Ilya开心地说道,父母告知他自己朋友也在平时使用ChatGPT,这令他感到十分惊喜。而当观众提问“你们正在创造历史,你们希望历史如何记住你们?”时,Ilya也风趣地回答道:“我的意思是,以最好的方式。”

以下为访谈全文:

一个读博一个辍学:两人在OpenAI前的不同人生

Ilya:

从5岁到16岁,我住在耶路撒冷。在2000年到2002年期间,我在开放大学学习。之后我搬到了多伦多大学,在那里度过了10年,并获得了学士、硕士和博士学位。在攻读研究生期间,我有幸为深度学习的重要进展做出贡献。随后,我与一些人共同创办了一家公司,并被谷歌收购,我在那里工作了一段时间。

然后,有一天我收到了山姆的一封邮件,他说:“嘿,让我们和一些很酷的人一起玩吧。” 我对此很感兴趣,于是去了。那是我第一次与Elon Musk和Greg Brockman见面,我们决定开启OpenAI的旅程。我们已经这样做了很多年,所以现在就是我们目前的位置。

Sam:

小时候,我对AI非常兴奋,是个科幻书呆子。从来没有想过有机会去研究它,但后来在大学时期,我开始研究了一段时间。但那时它还没有真正发展起来,就像是2004年……我辍学了,做过创业公司。

在Ilya提到的进展后,过了一段时间,我真的对AI所发生的事情感到兴奋,于是给他发了一封电子邮件,现在我们仍然在继续着。

OpenAI的优势所在

主持人:

你认为OpenAI的关键优势是什么,尤其是在竞争对手通常更大、拥有更多资源的情况下,使其成为生成人工智能的领导者?

Sam:

我们相信,关键优势在于我们更专注于我们所做的事情。相比于更大的公司,我们拥有更高的人才密度,这非常重要且容易被误解。我们的文化注重严谨和可重复创新,而令这两种文化并存是困难和罕见的。

Ilya:

是的,我只能在Sam的答案中添加少量内容。这是关于信仰的游戏,拥有更多的信仰意味着取得更大的进步。如果你有非常非常多的信仰,你就能实现最大的进步。听起来可能像是开玩笑,但实际上是真的。你必须相信这个想法并努力推动它,这是推动进步的原因。

学术界在AI领域的地位

主持人:

近期人工智能的进步主要是由行业推动的,你认为学术研究在该领域的发展中应该扮演什么角色?

Ilya:

学术界在AI领域的角色发生了重大变化。学术界曾经是AI研究的前沿,但现在情况已经改变了。原因有两个:计算能力和工程文化。学术界的计算能力较弱,并且通常缺乏工程文化。

然而,学术界仍然可以对AI做出显著和重要的贡献。学术界可以从我们正在训练的神经网络中解开许多谜团,我们正在创造出复杂而神奇的物体。

深度学习是什么?这是一个炼金术的过程,我们利用数据作为原材料,结合计算能源,从而获得了这种智能。但它究竟是什么?它是如何工作的?它具有什么属性?我们如何控制它?如何理解它?如何应用它?如何衡量它?这些问题都是未知数。

即使是简单的测量任务,我们也无法准确评估我们的AI的表现。过去这并不是问题,因为AI并不是那么重要。现在人工智能变得非常重要,但我们意识到我们还是无法完全衡量它。

因此,我开始思考一些无法由任何人解决的问题。你不需要庞大的计算集群,也不需要庞大的工程团队来提出这些问题并取得进展。如果你真的能有所突破,那将是一个引人注目且具有重大意义的贡献,每个人都会立刻关注。

主持人:

我们希望看到在工业界和学术界之间取得完全平衡的进步,我们希望看到更多这些类型的贡献。你是否认为可以做些什么来改善这种情况,尤其是从你的立场出发,是否可以提供某种支持?

Ilya:

首先,我认为思维方式的转变是第一,也是最重要的事情。这些天我有点远离学术界,但我认为我们正在做的事情存在一些危机。

有太多的动力围绕大量的论文,但重要的是要集中注意力解决最关键的问题。我们需要改变心态,专注于最重要的问题。我们不能只关注我们已经知道的事情,而是要意识到存在的问题。一旦我们理解了问题,我们就可以朝着解决它们的方向前进。

另外,我们可以提供帮助。例如,我们有学术访问计划,学术界可以申请获取计算能力,访问我们最先进的模型。许多大学已经使用GPT-3撰写论文,研究模型的属性和偏见。如果你有更多的想法,我很愿意听取。

开源OR不开源

主持人:

虽然有些参与者真正促进开源发布他们的模型和代码,但其他人做得不够。这也涉及到开放人工智能。所以我想知道,首先,你对此有何看法?如果你同意,为什么你认为OpenAI是正确的战略?

Sam:

我们开源了一些模型,并计划随着时间推移开源更多模型。但我不认为开源一切是正确的策略。如果今天的模型很有趣,它们可能对某些方面有用,但相对于我们即将创建的模型而言,它们仍然相对原始。我认为大多数人会同意这一点。如果我们知道如何制造一个超级强大的AGI,它有很多优点,但也有缺点,那么开源可能不是最佳选择。

因此,我们正在努力寻找平衡。我们会开源一些东西,随着我们对模型的理解不断深入,我们将能够随着时间的推移开源更多内容。我们已经发布了很多东西,我认为其他人现在在构建语言模型方面的许多关键想法都来自OpenAI的发布,例如来自rohf工作的早期GPT论文和缩放定律。但这是一个我们必须在前进过程中弄清楚的平衡。我们面临许多不同的压力,需要成功地管理它们。

主持人:

所以您是否正在考虑将模型提供给特定的受众,而不是向全世界开放源代码?对科学家来说,或者当我们完成GPT-4的培训时,您正在考虑的是什么?

Sam:

我们花了将近八个月的时间来理解它,确保其安全,并弄清楚如何进行调整。我们有外部审计员、红队和科学社区的参与。因此,我们正在采取这些措施,并将继续这样做。

AI不容忽视的风险

主持人:

我确实认为风险是一个非常重要的问题,可能至少有三类风险。

第一类是经济混乱,即工作岗位变得多余。第二类可能是少数人手中拥有强大武器的情况。例如,如果黑客能够使用这些工具,他们之前可能需要成千上万个黑客才能完成的事情。最后一类可能是最令人担忧的,即系统失去控制,甚至触发者无法阻止其行为。我想知道您对这些情况中每一种可能发生的情况有何看法。

Ilya:

好的,我们从经济混乱的可能情况开始讨论。正如您提到的,存在三个风险:工作岗位受到影响、黑客获得超级智能和系统失控问题。经济混乱的确是我们已经熟悉的情况,因为一些工作已经受到影响或面临风险。

换句话说,某些任务可以自动化。例如,如果您是一名程序员,Copilot可以为您编写函数。尽管这与艺术家的情况有所不同,因为艺术家的许多经济活动已经被某些图像生成器取代。

我认为这确实不是一个简单的问题。尽管会创造新的就业机会,但经济的不确定性将持续很长时间。我不确定是否会出现这种情况。

然而,在任何情况下,我们都需要一些东西来平稳过渡到新兴职业的冲击,即使这些职业尚不存在。这需要政府和社会系统的关注。

现在让我们谈谈黑客问题。是的,这是一个棘手的问题。人工智能确实非常强大,坏人可以以强大的方式使用它。我们需要应用类似于其他非常强大和危险工具的框架。

请注意,我们不是在讨论今天的人工智能,而是随着时间推移,功能不断增强。现在我们处于低点,但是当我们达到目标时,它将变得非常强大。这项技术可以用于惊人的应用,可以用来治愈疾病,但也可能创造出比之前任何东西更糟糕的疾病。

因此,我们需要适当的结构来控制这项技术的使用。例如,Sam已经向他们提交了一份文件,提出国际原子能机构类似于控制核能的框架,以控制非常强大的人工智能。

主持人:

最后一个问题是关于超级智能人工智能失控的问题,可以说它将成为一个巨大的问题,构建一个我们不知道如何控制的超级人工智能是不是一个错误。

Sam:

我可以补充一些观点。当然,对于最后一句话,我完全同意。

在经济方面,我发现很难预测未来的发展。我认为这是因为现在世界上存在着如此多的需求盈余,这些系统非常擅长帮助完成任务。但在今天的大多数情况下,并非所有任务都可以由它们完成。

我认为短期来看,情况看起来不错,我们将看到生产力显著增长。如果我们能让程序员的生产力提高两倍,那么世界上需要的代码量将增加两倍以上,所以一切看起来都很好。

从长远来看,我认为这些系统将处理越来越复杂的任务和工作类别。其中一些工作可能会消失,但其他一些工作将变得更像真正需要人类和人类关系的工作。人们真的希望人类在这些角色中发挥作用。

这些角色可能并不显而易见。举个例子,当深蓝战胜卡斯帕罗夫时,世界第一次见证了人工智能。当时每个人都说国际象棋已经结束了,没有人会再下国际象棋,因为没有意义。

然而,我们达成了共识,即国际象棋从未像现在这样流行。人类变得更强,只是期望值提高了。我们可以利用这些工具来提高自己的技能,但人们仍然真正喜欢下棋,而且人们似乎仍然关心其他人。

你提到多莉可以创造出伟大的艺术,但人们仍然关心他们想要购买的艺术作品背后的人,我们都认为这些创作者是特别而有价值的。

以国际象棋为例,就像人们更多地关注人类下棋一样,观看人类下棋的人比以往任何时候都更多。然而,很少有人愿意观看两个人工智能之间的比赛。因此,我认为它们将成为所有这些难以预测的因素。我认为人类渴望差异化(人类和机器之间)。

创造新事物以获得地位的需求将永远存在,但它将以一种真正不同的方式呈现出来。我敢打赌,从现在开始的100年工作将与今天的工作完全不同,其中许多事情将变得非常相似。但我真的同意Ilya所说的,无论发生什么,我们都需要一种不同的社会经济契约,因为自动化已经达到了迄今为止无法想象的高度。

主持人:

Sam你最近签署了一份请愿,呼吁严肃对待人工智能对人类存在的威胁。也许像OpenAI这样的公司应该采取措施来解决这个问题。

Sam:

我真的想强调,我们在这里讨论的不是今天的系统,也不是小型初创公司的训练模型,也不是开源社区。

我认为现在对该领域实施严格监管,或试图放慢令人难以置信的创新是错误的。真的不想创造一个看起来无可争辩的、不太一致的超级智能。我认为世界不应该将其视为永远不会出现的科幻风险,而是可能在未来十年中我们不得不面对的东西,适应某些事情需要时间,但这段时间不会很长。

因此,我们提出了一个想法,希望能有更好的想法。如果我们能够建立一个全球性组织,拥有计算能力和技术前沿的最高级别,可以制定一个框架来许可模型并审核它们的安全性,以确保它们通过必要的测试。这将有助于我们将这一问题视为非常严重的风险。我们确实在核能方面做了类似的事情。

津公网安备12011002023007号

津公网安备12011002023007号