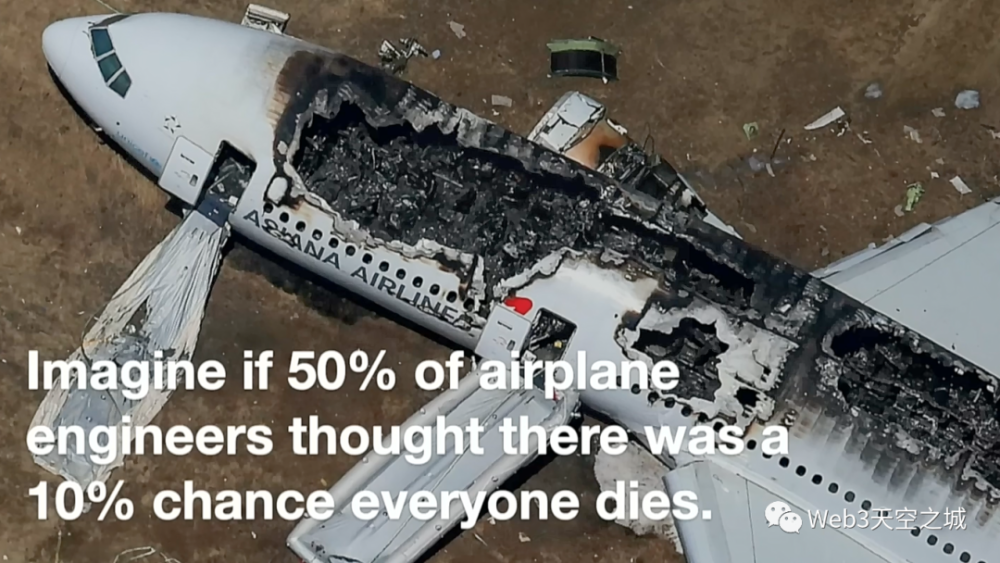

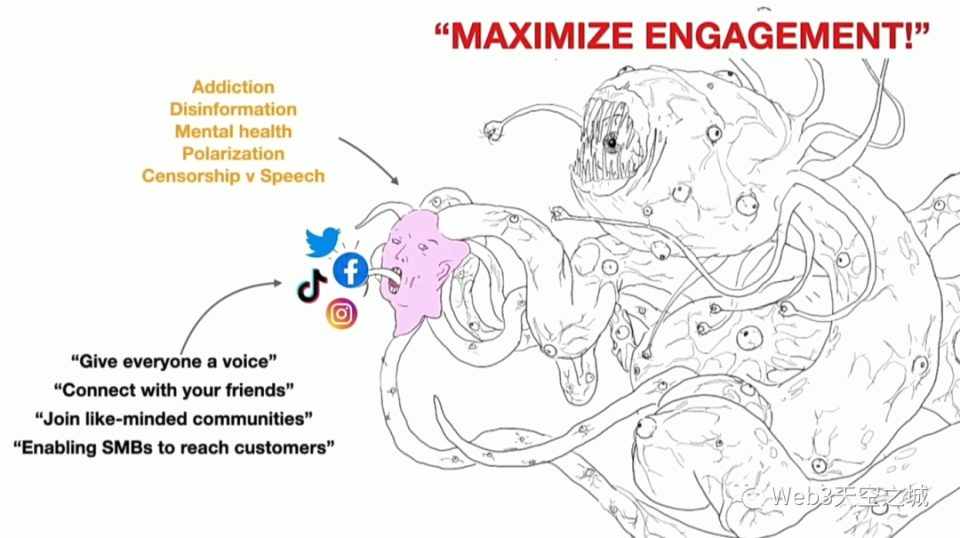

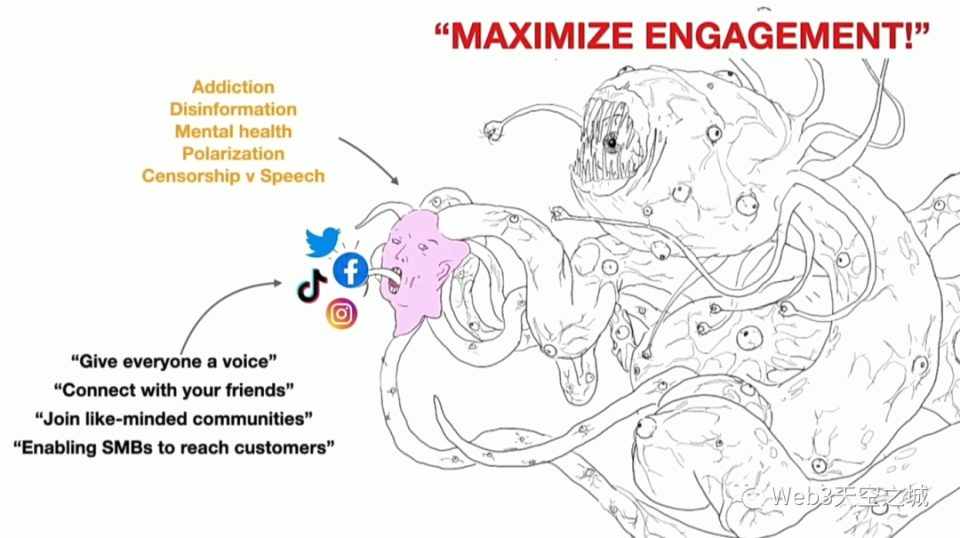

关于AI的潜在威胁,在媒体轰炸之下,我们大多人都能说上几条来,比如数据监控,数据造假,不透明性。

但若真是要讲清楚这些名词将如何系统性改变这个社会,尤其是去设想这些威胁具体落在社会的情况会怎样,那可能没有多少人能做得到。

但有两位演讲者做到了。

一个月前,Youtube上线了一条名为《AI困境》的视频,截至今天已经获得136万播放。就在上周,这条视频还累计得到了超过60万次播放。

关于AI的潜在威胁,在媒体轰炸之下,我们大多人都能说上几条来,比如数据监控,数据造假,不透明性。

但若真是要讲清楚这些名词将如何系统性改变这个社会,尤其是去设想这些威胁具体落在社会的情况会怎样,那可能没有多少人能做得到。

但有两位演讲者做到了。

一个月前,Youtube上线了一条名为《AI困境》的视频,截至今天已经获得136万播放。就在上周,这条视频还累计得到了超过60万次播放。