DeepSeek爆火原因:中国AI的崛起与全球影响(2025最新)

DeepSeek2025爆火原因:

DeepSeek(深度求索)作为中国AI领域的新兴力量,凭借其强大的技术实力和创新的商业模式,在全球范围内迅速崛起。其最新发布的DeepSeek-R1模型在性能和成本上的突破,使其在短短数日内超越ChatGPT,登顶美国和中国区苹果应用商店免费榜。这一成就不仅标志着中国在AI领域的重大突破,也引发了全球科技界的广泛关注和讨论。

一、DeepSeek的崛起背景

二、技术突破与产品发布

- 2023年11月29日:推出参数规模达670亿的通用大模型DeepSeek LLM。

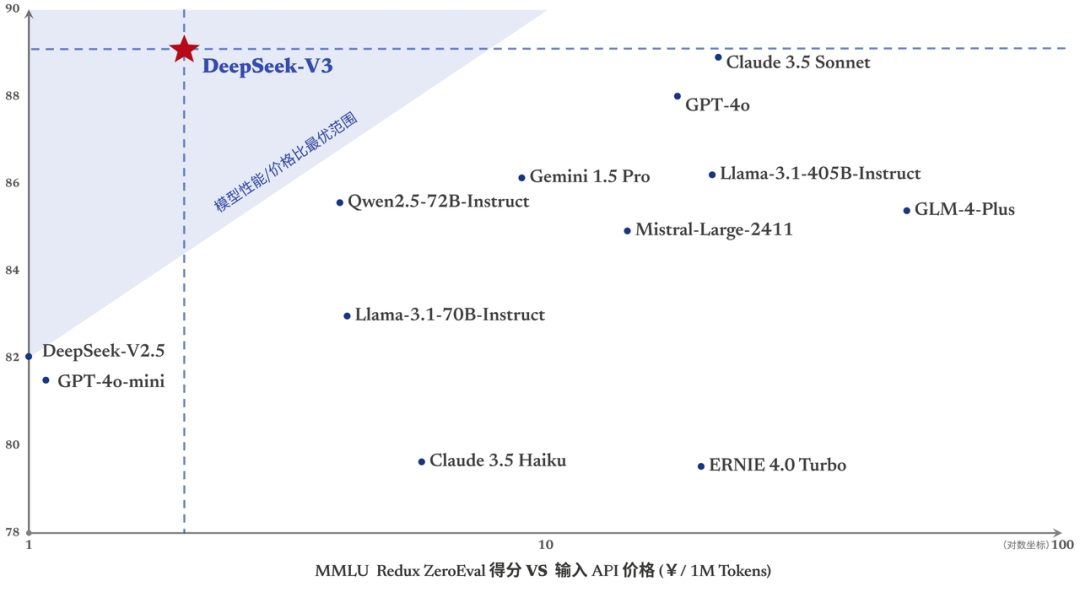

- 2024年12月26日:发布DeepSeek-V3,以极低的训练成本(557.6万美元)实现了与GPT-4o等顶尖模型相近的性能。

- 2025年1月20日:正式发布DeepSeek-R1推理模型,性能比肩OpenAI的o1正式版,API调用成本却低了90%-95%。

三、爆火的关键因素

- 高性能与低成本:DeepSeek-R1在数学、代码、自然语言推理等任务上表现出色,同时训练成本仅为OpenAI同类模型的十分之一。这种“性价比”优势使其在全球范围内迅速获得关注。

- 开源策略:DeepSeek坚持开源,其模型代码和训练方法完全公开,吸引了全球开发者的参与。开源模式不仅降低了AI技术的门槛,还促进了技术的快速迭代。

- 技术创新:DeepSeek通过优化算法和创新架构,在有限的硬件资源下实现了顶尖的模型性能。例如,DeepSeek-V3仅用2048块英伟达H800 GPU完成了6710亿参数的训练。

四、全球影响

- 技术冲击:DeepSeek的技术突破挑战了传统AI研发模式,推动了全球AI技术的创新。其开源模式和高性价比的模型,为AI技术的普及和应用提供了新的可能性。

- 市场冲击:DeepSeek的崛起引发了全球资本市场的波动。其低成本、高性能的模型对英伟达等AI芯片巨头构成了潜在威胁。

- 政策冲击:DeepSeek的成功引发了美国政府对中国AI技术的进一步关注和限制。美国政府甚至启动了对DeepSeek的国家安全调查。

五、未来展望

一、DeepSeek-R1,性能对标 OpenAI o1 正式版

今天,我们正式发布 DeepSeek-R1,并同步开源模型权重。

- DeepSeek-R1 遵循 MIT License,允许用户通过蒸馏技术借助 R1 训练其他模型。

- DeepSeek-R1 上线 API,对用户开放思维链输出,通过设置

model='deepseek-reasoner'即可调用。 - DeepSeek 官网与 App 即日起同步更新上线。

性能对齐 OpenAI-o1 正式版

DeepSeek-R1 在后训练阶段大规模使用了强化学习技术,在仅有极少标注数据的情况下,极大提升了模型推理能力。在数学、代码、自然语言推理等任务上,性能比肩 OpenAI o1 正式版。

在此,我们将 DeepSeek-R1 训练技术全部公开,以期促进技术社区的充分交流与创新协作。

论文链接: https://github.com/deepseek-ai/DeepSeek-R1/blob/main/DeepSeek_R1.pdf

蒸馏小模型超越 OpenAI o1-mini

我们在开源 DeepSeek-R1-Zero 和 DeepSeek-R1 两个 660B 模型的同时,通过 DeepSeek-R1 的输出,蒸馏了 6 个小模型开源给社区,其中 32B 和 70B 模型在多项能力上实现了对标 OpenAI o1-mini 的效果。

HuggingFace 链接: https://huggingface.co/deepseek-ai

开放的许可证和用户协议

为了推动和鼓励开源社区以及行业生态的发展,在发布并开源 R1 的同时,我们同步在协议授权层面也进行了如下调整:

- 模型开源 License 统一使用 MIT。我们曾针对大模型开源的特点,参考当前行业的通行实践,特别引入 DeepSeek License 为开源社区提供授权,但实践表明非标准的开源 License 可能反而增加了开发者的理解成本。为此,此次我们的开源仓库(包括模型权重)统一采用标准化、宽松的 MIT License,完全开源,不限制商用,无需申请。

- 产品协议明确可“模型蒸馏”。为了进一步促进技术的开源和共享,我们决定支持用户进行“模型蒸馏”。我们已更新线上产品的用户协议,明确允许用户利用模型输出、通过模型蒸馏等方式训练其他模型。

App与网页端

登录DeepSeek官网或官方App,打开“深度思考”模式,即可调用最新版 DeepSeek-R1 完成各类推理任务。

API 及定价

DeepSeek-R1 API 服务定价为每百万输入 tokens 1 元(缓存命中)/ 4 元(缓存未命中),每百万输出 tokens 16 元。

详细的 API 调用指南请参考官方文档: https://api-docs.deepseek.com/zh-cn/guides/reasoning_model

二、DeepSeek-V3

我们全新系列模型 DeepSeek-V3 首个版本上线并同步开源。

登录官网 chat.deepseek.com 即可与最新版 V3 模型对话。API 服务已同步更新,接口配置无需改动。当前版本的 DeepSeek-V3 暂不支持多模态输入输出。

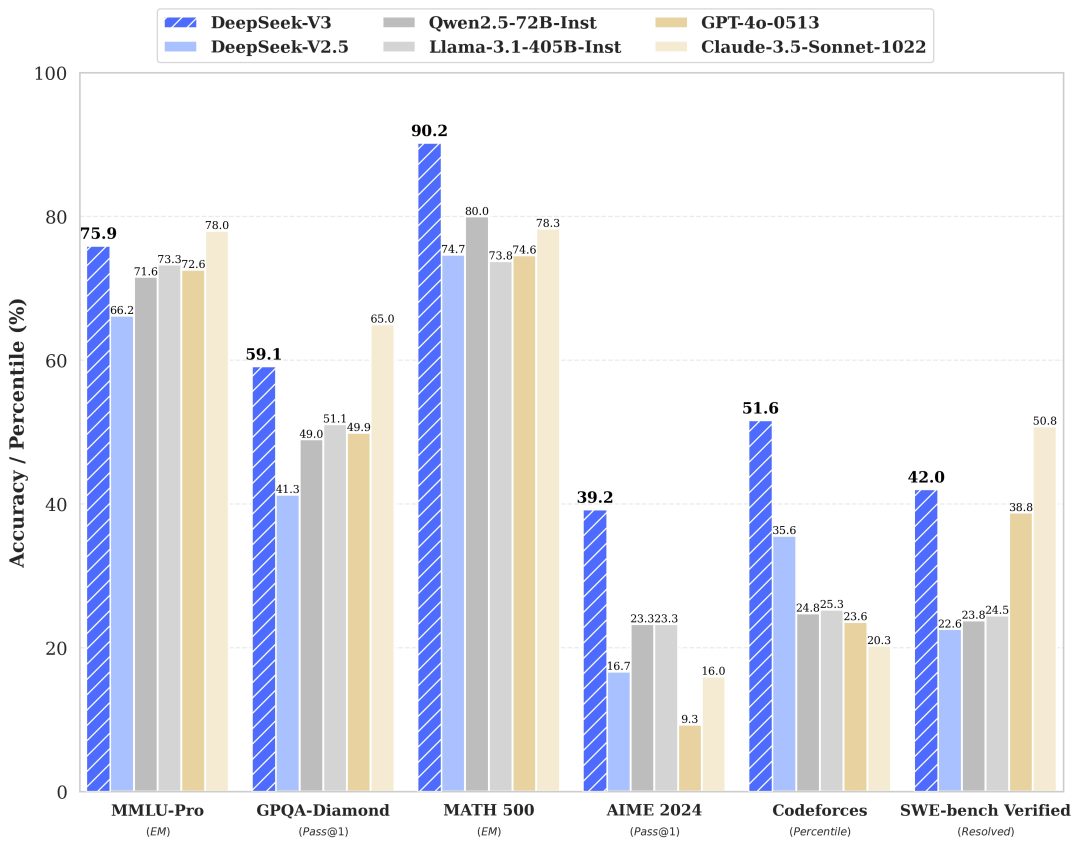

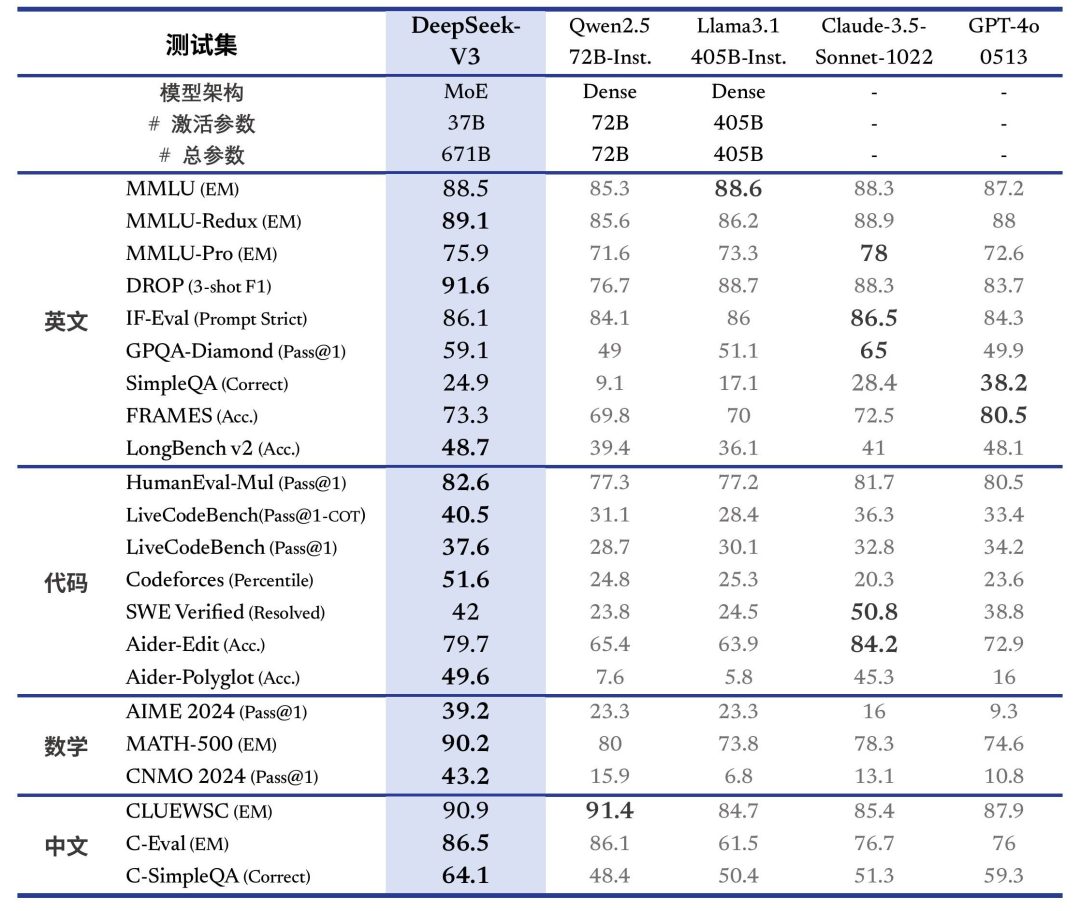

性能对齐海外领军闭源模型

DeepSeek-V3 为自研 MoE 模型,671B 参数,激活 37B,在 14.8T token 上进行了预训练。

论文链接:https://github.com/deepseek-ai/DeepSeek-V3/blob/main/DeepSeek_V3.pdf

DeepSeek-V3 多项评测成绩超越了 Qwen2.5-72B 和 Llama-3.1-405B 等其他开源模型,并在性能上和世界顶尖的闭源模型 GPT-4o 以及 Claude-3.5-Sonnet 不分伯仲。

- 百科知识: DeepSeek-V3 在知识类任务(MMLU, MMLU-Pro, GPQA, SimpleQA)上的水平相比前代 DeepSeek-V2.5 显著提升,接近当前表现最好的模型 Claude-3.5-Sonnet-1022。

- 长文本: 在长文本测评中,DROP、FRAMES 和 LongBench v2 上,DeepSeek-V3 平均表现超越其他模型。

- 代码: DeepSeek-V3 在算法类代码场景(Codeforces),远远领先于市面上已有的全部非 o1 类模型;并在工程类代码场景(SWE-Bench Verified)逼近 Claude-3.5-Sonnet-1022。

- 数学: 在美国数学竞赛(AIME 2024, MATH)和全国高中数学联赛(CNMO 2024)上,DeepSeek-V3 大幅超过了所有开源闭源模型。

- 中文能力: DeepSeek-V3 与 Qwen2.5-72B 在教育类测评 C-Eval 和代词消歧等评测集上表现相近,但在事实知识 C-SimpleQA 上更为领先。

生成速度提升至 3 倍

通过算法和工程上的创新,DeepSeek-V3 的生成吐字速度从 20 TPS 大幅提高至 60 TPS,相比 V2.5 模型实现了 3 倍的提升,为用户带来更加迅速流畅的使用体验。

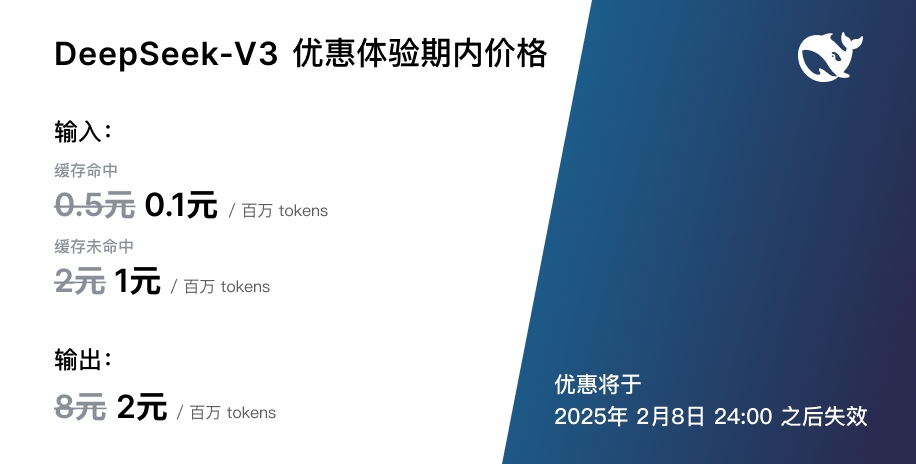

API 服务价格调整

随着性能更强、速度更快的 DeepSeek-V3 更新上线,我们的模型 API 服务定价也将调整为每百万输入 tokens 0.5 元(缓存命中)/ 2 元(缓存未命中),每百万输出 tokens 8 元,以期能够持续地为大家提供更好的模型服务。

与此同时,我们决定为全新模型设置长达 45 天的优惠价格体验期:即日起至 2025 年 2 月 8 日,DeepSeek-V3 的 API 服务价格仍然会是大家熟悉的每百万输入 tokens 0.1 元(缓存命中)/ 1 元(缓存未命中),每百万输出 tokens 2 元,已经注册的老用户和在此期间内注册的新用户均可享受以上优惠价格。

开源权重和本地部署

DeepSeek-V3 采用 FP8 训练,并开源了原生 FP8 权重。

得益于开源社区的支持,SGLang 和 LMDeploy 第一时间支持了 V3 模型的原生 FP8 推理,同时 TensorRT-LLM 和 MindIE 则实现了 BF16 推理。此外,为方便社区适配和拓展应用场景,我们提供了从 FP8 到 BF16 的转换脚本。

模型权重下载和更多本地部署信息请参考: https://huggingface.co/deepseek-ai/DeepSeek-V3-Base

“以开源精神和长期主义追求普惠 AGI” 是 DeepSeek 一直以来的坚定信念。我们非常兴奋能与社区分享在模型预训练方面的阶段性进展,也十分欣喜地看到开源模型和闭源模型的能力差距正在进一步缩小。

这是一个全新的开始,未来我们会在 DeepSeek-V3 基座模型上继续打造深度思考、多模态等更加丰富的功能,并将持续与社区分享我们最新的探索成果。

三、DeepSeek以往介绍

DeepSeek是杭州深度求索技术研究有限公司的简称。它是一家在人工智能领域积极探索的创新型科技公司,致力于开发先进的大语言模型(LLM)和相关技术,以满足人工智能领域的各种需求 。用长远的眼光来回答这个基本问题。🎉DeepSeek-V3现在完全开源可用,具有领先的性能和改进的速度。

这家公司由幻方量化孕育而生,幻方量化作为量化私募巨头,为DeepSeek提供了一定的资源基础,例如是大厂外唯一一家储备万张A100芯片的公司,这为其人工智能技术研发提供了强大的硬件支持 。

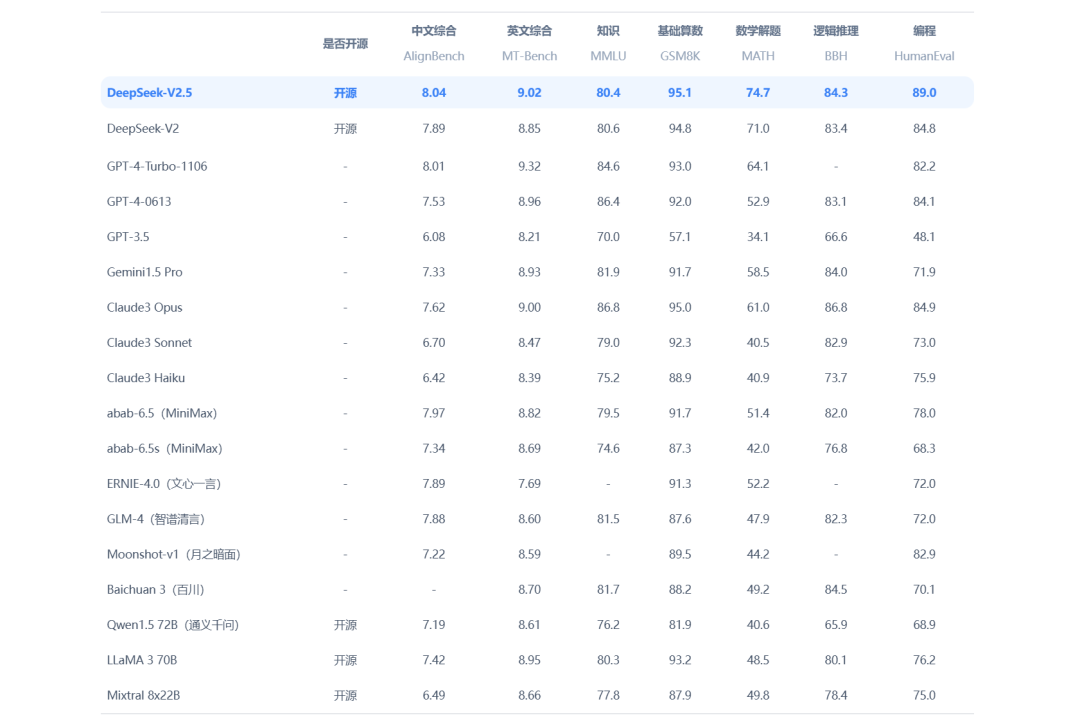

DeepSeek的产品和服务以其大语言模型为核心,通过不断的技术研发和创新,在人工智能领域逐渐崭露头角。例如,它推出的DeepSeek – V2模型在主要AI排行榜如AlignBench和MT – Bench中获得高分,展现出其模型的高性能 。

四、DeepSeek的特点和功能

(一)模型架构创新

- MLA架构

- DeepSeek提出了崭新的MLA(一种新的多头潜在注意力机制)架构。这种架构在降低显存占用方面有着显著的效果,能够把显存占用降到过去最常用的MHA架构的5% – 13%。这意味着在相同的硬件条件下,使用DeepSeek模型可以处理更多的数据或者更复杂的任务,提高了硬件资源的利用效率,降低了对硬件的依赖程度,从而降低成本 。

- DeepSeekMoESparse结构

- 独创的DeepSeekMoESparse结构把计算量降到极致。通过这种结构,模型在计算过程中可以更高效地处理数据,减少不必要的计算,进一步提高了模型的性能和效率。例如,在模型训练和推理过程中,能够更快地处理输入数据,得到输出结果,并且消耗更少的计算资源 。

(二)性能卓越

- 多语言处理能力

- DeepSeek在2万亿个中英文token的数据集上进行了预训练,这使得它具有强大的双语处理能力。在处理中英文混合内容或跨语言任务时,能够表现出更高的准确性和效率。例如,在翻译、跨语言文本生成等任务中,可以更好地理解不同语言的语义和语法结构,生成高质量的结果 。

- 综合能力表现

- DeepSeek – V2模型的综合能力非常出色。在中文综合能力方面,它在开源模型中表现最强,与GPT – 4 – Turbo、文心4.0等闭源模型在评测中处于同一梯队;在英文综合能力方面,也位于第一梯队,甚至超过了最强MoE开源模型Mixtral8x22B。此外,在知识、数学、推理、编程等榜单结果也位居前列,展现出其在多个领域的强大能力 。

(三)功能丰富

- DeepSeekCoder

- DeepSeekCoder是一款专门面向程序员的智能编程助手。它具有强大的代码生成能力,能够根据自然语言描述生成高质量的代码,大大提高了开发效率。例如,程序员可以用自然语言描述一个功能需求,如“编写一个计算两个数之和的Python函数”,DeepSeekCoder就能够生成相应的代码。同时,它还可以进行精准的代码补全,根据上下文智能地补全代码,帮助开发者更快地编写代码。并且能够深入理解代码结构和语义,为代码分析和重构提供支持,支持多种编程语言,适用于不同的开发场景 。

- DeepSeekAPI

- DeepSeekAPI为开发者提供了应用程序接口,使他们能够将DeepSeek的AI能力集成到自己的应用中。这一功能方便了开发者在各种应用和产品中利用DeepSeek的人工智能技术,如在智能客服系统、信息查询平台等的开发中,可以利用DeepSeekAPI集成智能查询服务,提高用户体验 。

五、DeepSeek的应用领域

(一)教育培训

- 个性化学习助手

- DeepSeek的对话系统可以用于创建个性化学习助手。在教育领域,每个学生的学习进度、知识掌握程度和学习方式都有所不同。DeepSeek的技术可以根据学生的提问和学习情况,提供即时解答和辅导。例如,对于数学学习中的难题,学生可以向DeepSeek提问,它能够详细解释解题思路和步骤;对于语言学习,它可以帮助纠正语法错误、提供词汇扩展建议等。这有助于提高学生的学习效率和学习效果,满足个性化学习的需求 。

(二)内容创作

- 灵感激发与内容优化

- 写作者和内容创作者可以使用DeepSeek的语言模型获取灵感、生成内容大纲或进行文本润色。当创作者面临创作瓶颈时,DeepSeek可以根据提供的关键词或者主题,生成一些创意性的想法和思路,激发创作者的灵感。在内容大纲生成方面,它能够根据主题构建出合理的框架结构。对于已经创作好的文本,DeepSeek可以对其进行语法、词汇等方面的优化,使文本更加通顺、准确和富有表现力 。

(三)科研探索

- 数据处理与分析

- 研究人员可以利用DeepSeekPlatform进行数据分析、模式识别等复杂的科研任务。在科学研究中,往往需要处理大量的数据,DeepSeek的模型可以对这些数据进行分析,寻找其中的规律和模式。例如,在生物学研究中,对基因序列数据的分析;在物理学研究中,对实验数据的处理等。它还可以协助研究人员进行文献综述,快速查找和整合相关领域的文献和资料,提高科研效率 。

(四)产品开发

- 智能化集成

- 通过DeepSeekAPI,开发者可以将先进的AI功能无缝集成到各种应用和产品中,增强其智能化水平。例如,在开发智能客服系统时,可以利用DeepSeek的自然语言处理能力,使客服系统能够更好地理解用户的问题并给出准确的回答;在智能家居系统中,可以集成DeepSeek的技术,实现对家居设备的智能控制和交互,提升产品的用户体验和竞争力 。

五、DeepSeek的发展历程

(一)早期基础

- 幻方量化的孕育

- DeepSeek源于量化巨头幻方量化。幻方量化在人工智能领域投入了大量的资源,其自研的深度学习训练平台萤火一号总投资近2亿元,搭载了1100块GPU;萤火二号的投入增加到10亿元,搭载了约1万张英伟达A100显卡。幻方量化多年以来坚持把营收的大部分投入人工智能领域,建设领先的AI硬件基础设施,进行大规模的研究,为DeepSeek的诞生奠定了坚实的基础 。

- 初始模型发布

- 2023年11月2日晚间,幻方探索AGI(通用人工智能)的新组织深度求索(即DeepSeek)在成立半年后,发布了第一代大模型DeepSeekCoder,并表示免费商用,完全开源。DeepSeekCoder已经开放内测,并且展示了如用Python写一个贪吃蛇游戏、修改UI生成2048游戏、测试bug、作为数据分析帮手学写SQL等功能,还开源了7B,33B全系列模型,包含Base模型和指令调优模型 。

(二)快速发展

- 价格战引发与模型升级

- 2024年5月6日,DeepSeek发布了第二代MoE模型DeepSeek – V2,这一事件引发了中国大模型价格战。DeepSeek – V2的API定价为每百万tokens输入1元、输出2元(32K上下文),价格仅为GPT – 4 – Turbo的近百分之一。它采用了创新架构,如在注意力方面设计了MLA(Multi – headLatentAttention)以减少KV缓存确保高效推理,对于前馈网络(FFN)采用DeepSeekMoE架构,能够以更低的成本训练更强大的模型。DeepSeek – V2总共包含236B个参数,每个token激活21B个,相比DeepSeekV1,实现了更强的性能,同时节省了42.5%的训练成本,减少了93.3%的KV缓存,并将最大生成吞吐量提高了5.76倍。这一模型在多个能力评测中表现出色,中文综合能力在开源模型中最强,英文综合能力也位于前列,知识、数学、推理、编程等榜单结果也位居前列,同时支持128K上下文窗口 。

- 持续创新与影响力扩大

- 2024年,DeepSeek – V2.5模型发布,它由deepseek – v2 – chat和deepseek – coder – v2两个模型合并升级而来。这个模型融合了chat模型的通用对话能力和coder模型强大的代码处理能力。在通用能力方面,无论是中文还是英文测试集,它都展现出了优于之前版本的性能;在模型安全方面做出了显著改进,对安全问题的边界进行了更清晰的划分,强化了对各种越狱攻击的安全性,减少了安全策略过度泛化到正常问题中的情况;在代码相关任务上表现卓越,在多项代码测试中取得了显著的成绩,并且由于与transformers框架完全兼容,在各种环境中的部署变得相对容易,已开源到了huggingface平台 。

津公网安备12011002023007号

津公网安备12011002023007号