FunAudioLLM – 阿里巴巴通义团队推出的开源语音大模型

一、FunAudioLLM的概述

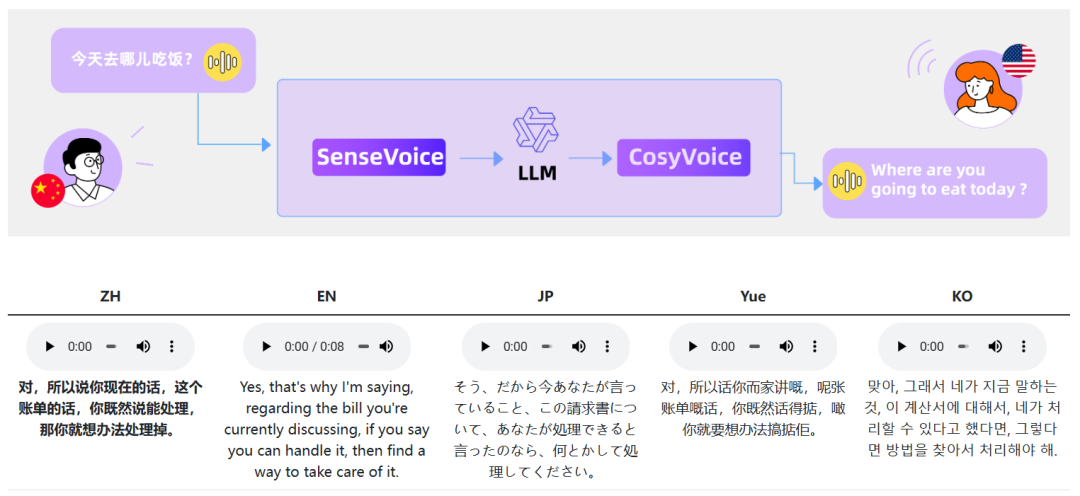

FunAudioLLM是由阿里通义实验室发布的开源语音处理框架,旨在增强人与大型语言模型(LLMs)之间的自然语音交互 。它是语音处理领域的一项重要成果,基于两个创新模型SenseVoice和CosyVoice构建而成。

SenseVoice主要负责多语言语音识别、情感识别以及音频事件检测等任务。比如它具有很强的多语言语音识别能力,训练数据超过30万小时,SenseVoice – Small能对5种语言(中文、英语、粤语、日语和韩语)进行自动语音识别,并且采用非自回归端到端架构,具有极低的推理延迟;SenseVoice – Large则支持超过50种语言的语音识别,在中文和粤语识别方面优势显著,还能够提供先进的情感识别和音频事件检测能力,例如可以识别多种情绪和交互事件,像音乐、掌声、笑声、哭声等 。

CosyVoice专注于自然语音生成,可控制多语言、音色、说话风格和说话者身份。在多语言语音生成、零样本上下文学习、跨语言语音克隆和指令跟随能力方面表现出色。例如它采用总共超15万小时的数据进行训练,支持中英日粤韩5种语言的合成。而且它仅需要3至10秒的原始音频,就能够生成模拟音色,包含韵律和情感等细节,甚至能够实现跨语言的语音生成。在模型构成上,CosyVoice包含回归变换器(用于生成输入文本的语音标记)、基于ODE的扩散模型(流匹配,用于从生成的语音标记重建梅尔频谱)以及基于HiFTNet的声码器(用于合成波形) 。

二、FunAudioLLM的特点

(一)多语言处理能力

- 语音识别方面

- FunAudioLLM中的SenseVoice – Large支持超过50种语言的高精度语音识别,这意味着在不同语言的语音识别任务中有很广泛的适用性。在一些特定语言如中文和粤语上,识别准确率与国际领先的模型相比有显著提升。例如在测试数据中,中文和粤语的识别准确度提升超过50%。这对于多语言环境下的语音交互十分重要,无论是在跨国交流场景还是多民族地区不同方言交流场景等都能发挥良好的作用 。

- 相比其他语音模型,许多模型虽然也支持多语言识别,但在特定语言(如中文和粤语)上的表现往往不如FunAudioLLM。像在识别准确度、推理速度等方面,FunAudioLLM都具有一定优势,为全球范围内的用户提供了便捷准确的语音识别服务 。

- 语音合成方面

- CosyVoice支持中英日粤韩5种语言的合成,能够在多语言环境下生成自然语音。并且可以根据少量原始音频快速模拟各种语言下包含韵律和情感细节的音色,实现跨语言的语音生成功能,例如可以将一种语言的原始音频音色特征应用到另一种语言的语音合成中,这对于多语言的内容创作、翻译等场景有很大的帮助 。

- 在语音合成的多语言支持上,与其他模型如Tacotron、FastSpeech等相比,FunAudioLLM在零样本语音生成和跨语言声音合成方面表现更为卓越。某些其他模型在语音合成方面虽然也不错,但在音色、情感的丰富度和自然度上可能略有不足,FunAudioLLM能够生成自然流畅的语音且在这些方面表现更好 。

(二)情感处理

- 情感识别

- SenseVoice具有情感识别能力,在测试数据上达到或超过当前最佳情感识别模型的效果,能够对语音中的情感状态进行分析,这通常涉及到对语音信号的音调、节奏、强度等特征的分析。例如可以识别出用户语音中的情绪(如高兴、悲伤、愤怒等)和交互事件(如音乐、掌声、笑声、哭声等),从而更好地理解用户的意图,在人机交互中提供更符合用户情感需求的回应,增强交互的自然性和人性化 。

- 情感生成与控制

- CosyVoice可以生成带有情感的语音。并且支持以富文本或自然语言精细控制生成语音的情感和韵律。比如在生成有声读物或者情感语音对话中,通过输入特定的富文本或者自然语言控制指令,就能调节语音的情感,使合成的语音在情感表现力方面得到提升,这是很多其他语音模型所不具备的功能特性 。

(三)技术架构与效率

- 采用先进技术

- 在技术方面,FunAudioLLM采用了先进的深度学习技术,如Transformer模型、语音量化编码技术、流匹配技术等,这些技术有助于提高模型在音频处理任务中的性能。例如Transformer模型能够有效捕捉语音中的长时依赖关系,承担重要的语音识别与合成任务;语音量化编码技术有助于对语音信号进行有效的数字化处理;流匹配技术在CosyVoice从语音标记重建梅尔频谱过程中发挥关键作用 。

- 高效的推理速度

- SenseVoice – Small采用非自回归端到端架构,这种架构让推理延迟极低,大大提高了模型的响应速度。例如其处理10秒音频的推理仅耗时70毫秒,速度是Whisper – large模型的15倍,能够满足实时语音交互的需求,使得用户在语音输入后可以快速得到模型的反馈,无论是语音识别还是后续的基于识别结果的交互操作都能更流畅地进行 。

- 依赖大量数据训练

- FunAudioLLM的模型训练依赖于大量的标注数据,包括语音、文本、情感标签等。多类型的大量数据有助于模型更精准地识别语音特征和生成自然语音。通过对海量数据的学习,模型能够更好地理解不同语音模式,提高语音识别的准确性以及语音合成的自然度和情感表现力等,并且可以适应更多复杂的应用场景 。

三、FunAudioLLM的应用场景

(一)语音到语音翻译

- 多语言转换

- 凭借SenseVoice的多语言语音识别能力以及CosyVoice的多语言语音合成能力,结合LLMs的语言处理能力,FunAudioLLM可以实现语音到语音的翻译(S2ST),而且能够翻译超过50种语言。例如用户可以用中文语音输入,FunAudioLLM能将其翻译成英语、日语或者粤语等多种目标语言的语音,并可在翻译过程中保留原说话人的音色和情感色彩,实现更加自然流畅的翻译效果,这在跨国交流、语言学习、旅游等场景中有很高的应用价值。在国际化的商务会议中,不同国家的人员可以更方便地借助这个功能进行实时的交流沟通,不需要人工操作的翻译介入就可以实现自然的语音交流;语言学习者也能够通过这个功能获得更加沉浸式的语言学习体验,一边听原语言一边听翻译后的语音,理解语言的实际运用 。

(二)情感语音聊天

- 情感交互回应

- 利用SenseVoice的情感辨识能力和CosyVoice的情感语音生成功能,FunAudioLLM可以实现与用户进行带有情绪色彩的语音对话。例如当用户以愉快的声调提问时,模型能够识别出这种情绪,并以同样积极的情绪语音进行回答,使得交互更加具有真实和沉浸感。在日常聊天场景中,无论是智能客服、个人助手还是社交娱乐软件中的聊天机器人,如果融入FunAudioLLM的情感语音聊天功能,都能够大大提升用户体验,建立与用户更加贴近的情感连接,让对话不再是机械的回答,而是带有情感共鸣的交互 。

(三)互动播客

- 语音内容生成

- CosyVoice的自然语音生成能力很强,借助这一能力,FunAudioLLM可以用来生成高质量的语音内容用于制作互动播客节目。主播可以利用FunAudioLLM快速生成不同音色、风格的语音片段,加入到播客节目中。听众在收听过程中也可以实时与节目内容进行交互,例如节目中涉及到问答环节时,可以借助FunAudioLLM的语音识别和语音合成功能实现实时互动,吸引更多的听众参与到播客节目中,改变传统播客单向传播的模式,提高播客的趣味性和互动性。对于播客创作者来说,这一功能可以降低制作门槛,提高制作效率,丰富节目形式和内容 。

(四)有声读物

- 提升情感表现力

- 通过结合SenseVoice对文本的分析能力(包括情感分析等)以及CosyVoice的语音合成技术,FunAudioLLM能够制作富有情感表达力的有声读物。在生成有声读物时,模型可以根据书中不同的角色情感、情节氛围等生成不同情感表现的语音。例如在描述恐怖情节时用低沉、紧张的语音,在描述欢快场景时用轻松、明亮的语音。这为有声读物的制作提供了更加丰富的创作手段,不仅能提高有声读物的质量,还能够吸引更多的听众阅读有声读物,为视力障碍者或者喜欢听书的人群提供更加优质的阅读体验 。

四、FunAudioLLM与其他类似模型的比较

(一)功能任务覆盖全面性

- FunAudioLLM的功能整合

- FunAudioLLM包含的SenseVoice和CosyVoice两个模型分别致力于语音理解(多语言语音识别、情感识别和音频事件检测)和语音生成(多语言、音色、说话风格和说话者身份的自然语音生成)多个核心任务领域。这两个模型相互协同与LLMs集成后,可以实现语音到语音翻译、情感语音聊天、互动播客和有声读物等多种功能,集成度高并且功能全面,一站式满足了语音交互场景下的多任务需求 。

- 其他模型的功能侧重性

- 而其他语音模型如Whisper、Tacotron、FastSpeech等,通常侧重于单一的语音识别或语音合成任务。例如Whisper主要侧重于语音识别任务,Tacotron和FastSpeech更多是专注于语音合成方面。虽然有的模型也在多个任务上有所兼顾,但相比FunAudioLLM在功能任务的全面性上可能不够精细和完整。在情感识别与生成、音频事件检测、多语言支持等多任务综合能力方面,可能落后于FunAudioLLM,像一些模型可能无法同时很好地兼顾多语言识别、情感识别以及语音合成等多个复杂任务 。

(二)性能表现

- 语音识别性能

- 在语音识别方面,FunAudioLLM(SenseVoice)支持超过50种语言,在中文和粤语上识别效果尤为显著。识别准确率相比国际领先的一些模型有显著提升。并且SenseVoice – Small具有极低的推理延迟,以极低的计算成本实现快速的语音识别。例如在与Whisper的对比中,SenseVoice – small采用非自回归端到端架构,推理延迟极低,比Whisper – small快7倍,比Whisper – large快17倍。其他模型虽然也支持多语言识别,但在特定语言,特别是像中文和粤语这样具有一定语言特点的语种上,识别准确率、推理速度等性能表现可能不如FunAudioLLM 。

- 语音合成性能

- FunAudioLLM(CosyVoice)在语音合成方面表现卓越,能够生成自然流畅的语音,支持多语言、音色和情感控制,在零样本语音生成和跨语言声音合成方面具有独特优势。对比像Tacotron、FastSpeech等模型,这些模型在语音合成方面虽然也有不错的表现,但可能在音色、情感的丰富度和自然度上略显不足,FunAudioLLM在合成语音的质量上,尤其是在音色模拟逼真度、情感表达丰富性等方面更胜一筹 。

(三)技术先进性

- 采用的技术手段

- FunAudioLLM采用了一系列先进的深度学习技术,如Transformer模型、语音量化编码技术、流匹配技术等提升音频处理性能。这些技术共同作用,使模型能够更好地进行语音识别、语音合成以及中间的各类转换操作。例如Transformer架构在处理语音中的长时依赖关系方面有着重要作用,语音量化编码技术有助于优化语音信号的表示和处理,流匹配技术很好地解决了像从语音标记重建梅尔频谱这样的关键问题 。

- 数据利用

- 在模型训练过程中,FunAudioLLM利用了大量的标注数据,包括语音、文本、情感标签等。这些多类型的数据被用来全方位地训练模型,使得模型能够从不同维度学习语音相关的知识和模式。而其他语音模型虽然也采用深度学习技术且利用数据,但在具体的数据类型利用或者数据与技术的结合方式上可能存在差异,导致在模型性能提升效果上可能不如FunAudioLLM 。

五、FunAudioLLM的发展前景

(一)应用拓展潜力

- 在新兴行业的应用拓展

- 随着人工智能技术在更多新兴行业的渗透,FunAudioLLM具有很大的应用拓展潜力。在虚拟现实(VR)或增强现实(AR)领域,FunAudioLLM可以用于为虚拟角色提供自然的语音交互服务。例如在VR的沉浸式游戏场景中,游戏中的角色通过FunAudioLLM能够实现与玩家自然流畅的语音对话,基于其多语言、情感丰富、响应快速等特点,大大增强游戏的沉浸感和交互性。在远程医疗场景中,FunAudioLLM的语音识别和情感识别能力有助于医生与患者之间进行更准确的交流,例如通过识别患者语音中的情绪状态辅助医生判断病情的严重性或者患者的心理状态,多语言支持功能也方便不同地区、不同语言背景的患者就医交流。

- 现有应用场景的深化

- 在目前已经表现出优势的应用场景如语音到语音翻译、情感语音聊天、互动播客和有声读物等方面,还有很大的深化空间。以语音到语音翻译为例,随着机器翻译技术的不断发展,FunAudioLLM可以结合新的翻译算法或语言模型不断提高翻译的准确性和效率,进一步优化对于不同口音、方言在多语言之间的翻译能力,并且能够根据不同的使用场景(如商务、学术、旅游等)定制更加精准的翻译服务。在情感语音聊天场景,能够深化对复杂情感的识别和回应,不仅仅是简单的基本情绪识别,还可以对混合情感或者深层次的情感暗示做出准确的交互反应,使得人机情感交互更加细腻真实。

(二)社区发展助力

- 数据和模型改进方面

- 目前FunAudioLLM项目鼓励社区成员贡献数据、模型改进和应用案例,这将为模型的持续优化提供强大的动力。随着更多的社区成员参与进来,更多种类、更多场景下的语音数据将被收集,这有助于提升模型在不同应用场景下的准确性和普适性。例如全球各地的用户可以上传自己当地特有的语音样本、具有特殊情感特征的语音等,这些数据被用于模型的训练将使模型能够更好地适应全球不同的语音环境。社区成员对模型改进提出的建议和代码提交,也能够促使技术团队进一步优化模型的架构或者算法,提升模型的性能和效率。

- 创新应用开发

- 社区成员的参与还有利于创新应用的开发。不同背景的开发者可以利用FunAudioLLM创建出各种新颖的语音应用。比如音乐创作者可以利用FunAudioLLM的语音合成技术创作有声的音乐故事,将音乐与带有情感的语音叙述相结合;教育工作者可以开发出更加生动有趣的语音教学工具,利用FunAudioLLM的多语言、情感交互等功能来提高学生的学习积极性和学习效果等。众多独具创意的应用开发,不仅能够丰富VoiceLLM的应用生态,还能够进一步提升其知名度和影响力,吸引更多的用户和开发者参与到项目中来。

(三)技术发展空间

- 算法优化方向

- 在技术上,FunAudioLLM可以不断对现有的算法进行优化。例如进一步优化Transformer模型在语音任务中的应用,提高对长时依赖关系的处理精准度,从而提升语音识别和合成的质量。可以探索新的语音量化编码技术或者改进流匹配技术等,使语音数据的处理更加高效、准确。还可以研究更加先进的情感识别算法,对于情感状态的识别不仅仅局限于基本的几个类别,能够细分到更多微妙的情感变化,进一步提升情感语音交互的质量。

- 融合其他技术的潜力

- 此外,FunAudioLLM还有很大的潜力融合其他先进技术。如融合区块链技术,在语音数据的安全存储和共享、版权保护等方面提供新的解决方案;与量子计算技术相结合,利用量子计算强大的计算能力来加速模型的训练和优化过程,提高模型的性能;或者与新出现的人工智能技术如新的强化学习算法、无监督学习技术等融合,使模型在语音处理的自我学习、自适应能力等方面得到提升。

津公网安备12011002023007号

津公网安备12011002023007号