GPT-SoVITS – 开源的声音克隆项目,只需少量数据即可合成声音

一、GPT – SoVITS概述

GPT – SoVITS是B站大佬花儿不哭开源的低成本AI音色克隆软件,遵循MIT协议,旨在造福所有普通人。它是一个强大的零样本语音转换和文本到语音WebUI,将语音合成与GPT的优势相结合,在语音合成领域展现出独特的性能和功能特点 。

(一)模型的发布与可使用平台

- GPT – SoVITS于2024年2月18日发布,可运行于Linux、MacOS (macOS14及以上)和Windows系统上,具有较高的灵活性和兼容性,适应多种操作系统环境供给用户使用 。

- 如果本地电脑不满足运行条件,用户还可以选择云环境操作。例如,在好易社区制作了GPT – SoVITS最新版本的镜像,平台提供一定的免费额度(可体验2个多小时),用户可以通过相应的操作启动和使用程序,如启动容器实例后点击对应实例的JupyterLab,再打开启动器并点击重启按钮以启动GPT – SoVITS主程序等操作流程 。

(二)安装与部署

- 以Ubuntu系统为例,使用特定脚本即可安装GPT – SoVITS。

- 安装过程中涉及到一些环境要求,如在训练环节不支持10系之前的所有显卡型号、GTX1060及以下、GTX1660及以下、GTX2060及以下以及3050 4GB显卡;若没有显卡则会自动切换为CPU训练,但速度非常慢。在推理环节,需支持CUDA的nVIDIA显卡,显存至少4GB(未经过测试,推测3GB可能无法完成语音合成)。对于Mac环境,有特定的软件要求,如要确保已通过运行xcode – select – – install安装Xcode命令行工具,还可能需要安装conda和FFmpeg等软件 。

二、GPT – SoVITS的特点

(一)零样本与少样本语音合成

- 零样本语音合成(Zero – ShotTTS):这是GPT – SoVITS的一大显著特点。用户只需输入短短5秒的语音样本,模型就能立即将文本转换为语音,无需额外的训练数据,极大地提高了语音合成的效率和便捷性。这得益于模型对语音特征的深度理解以及强大的泛化能力,尽管只有少量语音样本信息,也能生成自然流畅的语音 。

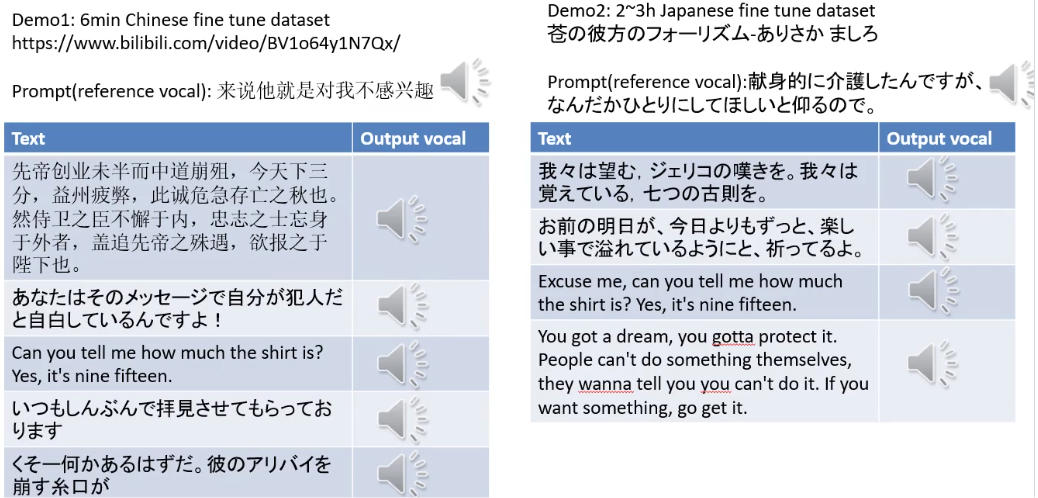

- 少样本语音克隆(Few – ShotTTS):GPT – SoVITS还支持少样本语音克隆,仅需1分钟的训练数据就能对模型进行微调,从而显著提升生成语音与参考语音的相似性和真实感。这使用户可以凭借较少的数据量创建出高质量、个性化的语音克隆模型,可满足如为虚拟角色赋予独特音色等特定的语音合成需求 。

(二)跨语言支持

GPT – SoVITS具备出色的跨语言支持能力,目前已支持英语、日语、中文、韩语和粤语等多种语言。例如,用户能够使用某一种语言(如中文)的语音样本来训练模型,然后以此为基础生成其他语言(如英文或日文)的语音内容,这一功能为跨国交流、多语言内容创作等提供了有力的支持,使模型能够更好地适应多语言环境下的语音合成和翻译需求 。

(三)集成WebUI工具

- 为了便于用户操作和进行数据处理,GPT – SoVITS提供了一系列实用的集成WebUI工具。

- 其中包括语音和伴奏分离工具,能将音频中的语音与伴奏分离开来;自动训练集分割工具,可以对训练集进行自动分割;中文自动语音识别(ASR)工具;还有文本标记工具等。这些工具对于创建训练数据集和构建GPT / SoVITS模型非常有帮助,尤其适合初学者,有效降低了使用门槛,提高了模型的整体可操作性,吸引更多人参与到语音合成的实践与创新中 。

(四)基于相关研究成果并有所创新

GPT – SoVITS基于近期语音合成和变声器模型(如VITS等)的研究成果构建。VITS模型通过引入流模型、结合归一化流去除说话人特征以及使用对抗训练过程提高语音合成性能。而GPT – SoVITS在这些成果的基础上进一步改进和优化,在零样本和少样本语音合成任务方面以及跨语言合成上取得显著突破,在模型结构和技术应用上体现了高效性与灵活性 。

(五)隐私和安全方面的考虑

GPT – SoVITS强调用户隐私与数据安全,能够完全在本地运行,不需要联网操作,可以有效避免隐私泄露风险,这一特性在处理用户敏感信息,如特殊语音内容或者涉及隐私的语音合成场景中显得尤为重要,为用户提供更安心的数据使用环境。这使得在广泛的应用场景中,如个人隐私敏感的语音辅助等,用户无需担心数据隐私问题 。

三、GPT – SoVITS的应用场景

(一)内容创作

- 在影视、动画、游戏等内容创作领域,GPT – SoVITS有着极为广泛的应用前景。

- 例如在游戏开发方面,游戏开发者仅利用少量角色的语音样本,就能依靠GPT – SoVITS为游戏中的大量角色生成丰富的语音内容。这不仅能够大大提升游戏开发效率,还能显著增强游戏的沉浸感,为玩家提供更加逼真、生动的游戏体验。

- 在动画制作中,动画制作团队可以凭借GPT – SoVITS快速且准确地为动画角色进行配音工作。利用该模型快速生成符合角色特征(如性格、年龄、身份等)的语音,有助于使动画角色更加拟人化和生动形象,从而全面提升作品的艺术质量和观赏性 。

(二)智能客服

- 在当下人工智能技术广泛应用于客户服务领域的趋势下,GPT – SoVITS为智能客服系统带来新的优化方向。企业能够运用该模型为智能客服生成更加自然、流畅且亲切的语音内容。

- 同时,借助模型定制不同风格和语气的语音,可以满足各种各样客户群体的需求。通过提供更加人性化的语音交互体验,让智能客服与客户之间的交流更为顺畅自然,进而提升客户服务体验,提高客户的满意度与忠诚度 。

(三)语言学习

- 在语言学习过程中,GPT – SoVITS也能够发挥独特的辅助作用。

- 对于学生而言,该模型可以生成多种语言、不同语音风格的语音示例,这些示例有助于学生更好地理解和模仿正确发音。学生可以借助模型生成的语音来针对性地练习听力和口语技能,从而提高自身语言学习的实际效果。

- 教育机构方面,可利用GPT – SoVITS来制作有声教材、在线课程等多样化的学习资源,为学生提供更加丰富多样的学习材料选择和更灵活的学习方式,丰富语言学习的视觉和听觉元素,提高学习的效果和趣味性。

(四)无障碍服务

- GPT – SoVITS为视障人士等特殊群体提供重要的无障碍语音信息服务。

- 它能够将文字内容有效地转换为自然流畅的语音,以方便视障人士顺利地获取各种信息。例如视障人士可以通过这个功能轻松阅读新闻、书籍、网页等内容,从而大大提升其生活与工作的便利性,有效地促进信息在特殊群体中的无障碍传播。这一应用体现了人工智能技术在社会公益领域的积极价值和重要意义,有助于构建更加包容的信息社会环境 。

(五)个性化语音相关应用

- 个性化语音助手:用户能够根据自己或者亲友的声音定制语音助手。通过GPT – SoVITS克隆出想要的声音并应用到智能设备的语音助手功能中,这种定制化方式可以极大地提升人机互动体验,让语音助手变得更加亲切和人性化,就如同与熟人对话一般自然。

- 语音娱乐应用:用户可以使用GPT – SoVITS制作恶搞音频或者模仿明星声音等富有趣味性的内容。例如在社交娱乐平台上,制作一些有趣的语音特效或者制作明星声音的趣味模仿、创作独特的语音短视频等,为广大用户提供丰富多样的娱乐体验 。

(六)语音备份与恢复

GPT – SoVITS可以为那些需要保存或恢复特定声音的个人(如纪念故人声音等)或机构(如保护历史语音资料等)提供可行的解决方案。利用模型对声音进行克隆保存,在需要的时候进行恢复和重新利用,在文化传承、个人情感纪念等方面有着特殊意义和不可替代的价值。

四、GPT – SoVITS的技术原理

(一)模型核心架构基于Transformer结构

GPT – SoVITS的技术核心为其独特的基于多层Transformer机构的模型架构。Transformer结构因其能够有效地捕捉到语音信号中的长距离依赖关系而被应用于GPT – SoVITS模型当中,这种架构有助于模型生成更加自然、连贯的语音波形。通过多层的组合与计算,可以更好地处理语音信号中的复杂语义和声学信息。

(二)结合自监督学习和对抗训练的训练策略

- 在训练策略上,GPT – SoVITS采用了自监督学习和对抗训练相结合的方式。

- 自监督学习:模型通过大量的语音数据自行学习语音中的各种规律和特征。例如在语音的韵律、语调、音色等方面进行数据挖掘,从而建立起语音信号内部的复杂关系模型,这有助于在没有明确的标记数据情况下学习声音的基本特性,为产生具有相似感觉的语音合成提供基础。

- 对抗训练:通过设置生成器和判别器进行对抗式训练。生成器努力生成与真实语音难以区分的语音,而判别器则尽可能准确地区分生成语音与真实语音。这样的互动训练过程会促使生成器不断优化生成的语音,使得生成的语音在音色、韵律、真实性等多方面不断接近真实的语音样本,最终提高语音合成的质量。

(三)独特的编码和解码操作

编码环节(t2s_encoder):从输入的文本、参考文本和特征向量生成声学token。首先运用g2p将text_seq和ref_seq转换为音素,在符号转换模块(symbol.py )中将它们转换为token序列(对于日语,g2p转换不带重音符号)。并且针对ref_audio,在其末尾附加0.3秒的静音,然后用cnhubert将其转换为名为ssl_content的特征向量,最后t2s_encoder将ref_seq、text_seq和ssl_content作为输入,并逐个输出token(有1025种,其中1024种表示EOS – End of Sequence),这里使用top – k和top – p采样方法操作,当出现EOS token时停止生成。

解码环节:将在编码阶段产生的声学token转换回波形从而得到合成的语音波形,实现将编码后的信息重新还原成语音信号的过程,完成从数据到语音的完整转换工作。在这个转换过程中依托模型的参数和结构不断调整还原的准确性和真实性,确保生成的语音质量。

津公网安备12011002023007号

津公网安备12011002023007号