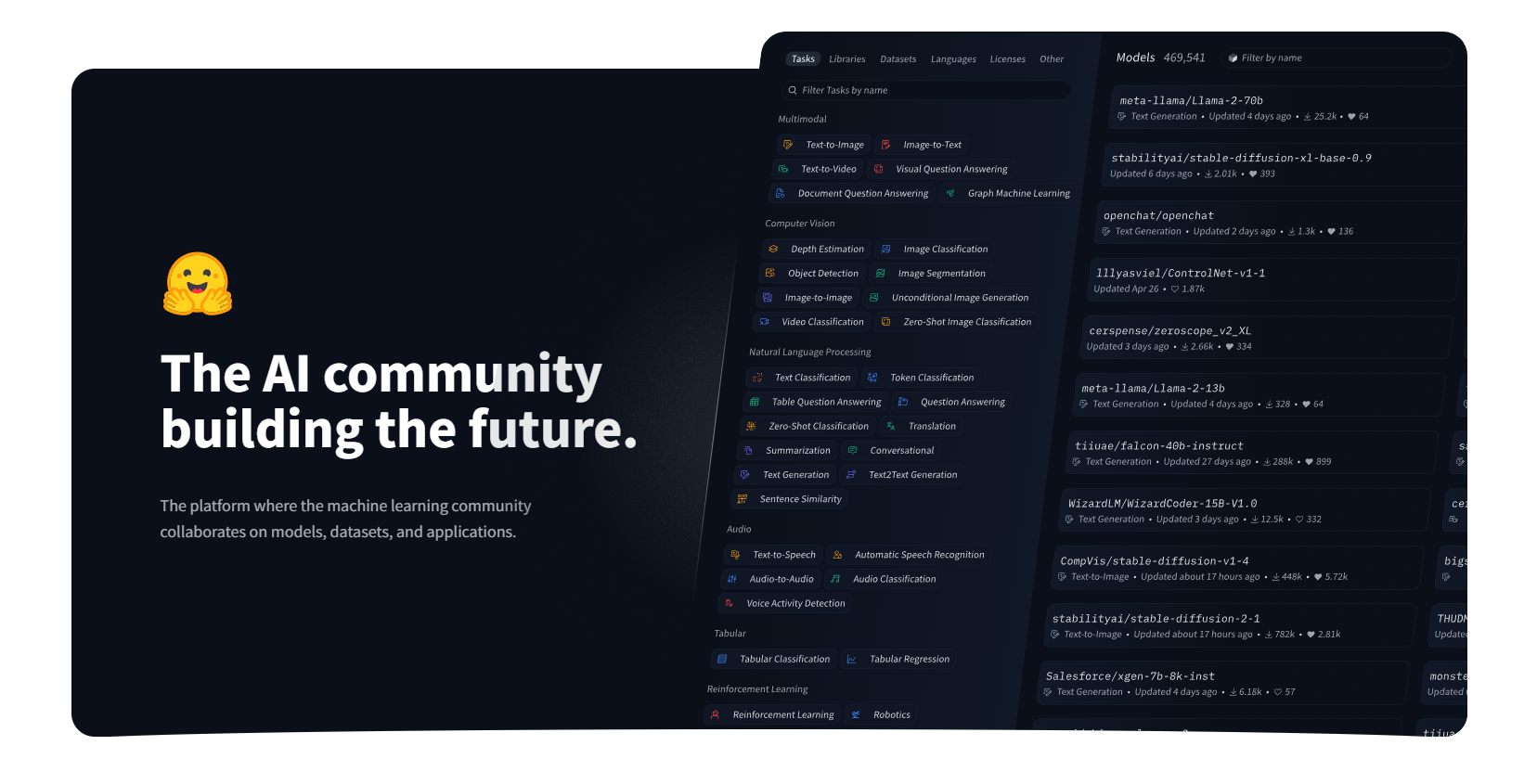

Huggingface – 模型、数据集和应用程序协作AI社区平台

一、HuggingFace的概述

HuggingFace是一家在人工智能领域具有重要影响力的公司,它就像是一个构建未来的AI开源社区,常被称为“AI领域的Github”。

HuggingFace的一个重要组成部分是名为Transformers的自然语言处理库。这个库在GitHub上相当受欢迎,拥有62,000颗星和14,000个分叉,这表明开发人员和数据科学社区正在积极使用和改进HuggingFace的技术。此外,HuggingFace还拥有其他丰富的产品和服务,例如Datasets(应用于多模态模型的数据集),Hub(模型和数据集的托管服务),Tokenizers(高速分词器,帮助把数据转化成模型能理解的形式)等。

该公司以其在人工智能领域,尤其是自然语言处理(NLP)方面的贡献而闻名。他们提供了丰富的预训练模型、工具函数、数据集等资源,并支持多种编程语言和框架,如Python、R、PyTorch、TensorFlow等,以帮助开发者和研究者更好地进行AI相关的开发和研究工作。

二、HuggingFace的特点和优势

(一)丰富的预训练模型资源

HuggingFace提供了大量的预训练模型,涵盖了如Transformer架构的诸多变体,像BERT、GPT、RoBERTa、T5、ELECTRA等众多知名模型。这些模型广泛覆盖各类NLP任务,例如文本分类、命名实体识别、情感分析、问答系统等,无论开发者是进行基础的NLP开发还是针对特定领域的应用构建,都能找到合适的预训练模型作为起点,大大节省了模型训练的时间和成本。据统计,其整合了数量惊人的超过47万个开源且预先训练完毕的AI模型,这极大地降低了开发AI产品所需的时间与成本,使开发者能够便捷地下载并运用这些模型进行开发工作。

(二)多模态处理能力

不仅仅局限于自然语言处理,HuggingFace还对图像、音频和视频等多种媒体类型提供支持,这一特性拓展了AI的应用场景。例如在处理包含文本、图像等多类型数据的任务时,可以利用HuggingFace的多模态处理能力构建更为复杂和智能的应用,实现跨模态的信息交互和融合,这在多媒体分析、智能交互系统等现代AI应用场景中具有重要意义。

(三)方便的API服务

HuggingFace提供了模型推理API,让用户无需下载模型就能进行模型调用。这一功能特别有利于在资源受限的环境下使用AI模型,或者对于那些只需要进行模型推理而不需要深入调整模型结构的用户来说非常便捷。开发者可以直接通过API与HuggingFace的模型进行交互,将模型集成到自己的应用中,加速开发进程。

(四)开源共享的生态

HuggingFace最大的亮点之一是其开源共享的理念。在这个平台上,所有的模型、数据集和工具都是开放的,任何人都可自由地访问、使用和修改。这种开源生态吸引了大量的开发者和研究人员参与其中,形成了一个庞大而活跃的社区。通过社区,人们可以共享预先训练好的模型、数据集以及机器学习项目的演示实例等。同时,社区也促进了知识的传播和交流,经验丰富的开发者可以分享自己的经验和代码,新手也可以在社区中寻求帮助、解决遇到的问题,而且HuggingFace还会定期举办线上和线下的技术交流活动,推动整个AI技术不断发展进步。

(五)完备的工具套件

除了预训练模型之外,HuggingFace还拥有为NLP任务精心打造的工具套件。例如其Transformers库不仅是一个模型的集合,还提供了一整套用于加载、微调和部署这些模型的工具和API,从而大大简化了构建NLP应用程序的流程。并且Datasets库收集了各种常见的NLP数据集,涵盖文本分类、问答、语言翻译等任务的数据,还提供了数据清洗、分割、转换等丰富的数据处理功能,如文本标准化、词汇表构建、数据切分等,方便开发者更好地准备数据用于模型训练和评估。同时,Tokenizers库实现了各种文本编码和解码算法,包括词级别和字级别的编码方式,能够将文本转换成模型所需的输入格式,并且支持各种语言和符号的处理,保证了模型的稳健性和泛化能力,这一系列工具可以全方位地满足从数据处理到模型开发部署过程中的各种需求。

三、HuggingFace的应用场景

(一)自然语言处理领域广泛应用

- 文本分类

- 在新闻分类、电影评论分类等场景中被广泛使用。HuggingFace提供的预训练模型具备强大的特征提取能力,可以对文本进行自动分类。例如,媒体公司可以利用它将新闻快速分类到不同的板块如政治、娱乐、体育等。对于电影评论网站,能将用户评论准确分类为正面评价或负面评价,帮助用户快速了解电影的大众口碑。

- 企业也可以应用文本分类技术对大量的内部文档进行分类管理,提高文档管理的效率和准确性。

- 情感分析

- 在评论情感分析、社交媒体情感分析等方面有着重要作用。通过HuggingFace的情感分析模型,可以判断文本的情感倾向,如判断用户在社交媒体上对某个产品或事件的态度是正面、负面还是中性。企业可以借此了解消费者对其产品的满意度,及时调整产品策略或应对公关危机;营销公司也可以根据情感分析结果优化广告投放策略,针对不同情感倾向的受众群体制定个性化的营销方案。

- 命名实体识别

- 能够自动识别文本中的命名实体,如人名、地名、组织名等。在信息检索、知识图谱构建、文档分析等领域大有可为。例如在搜索引擎的优化中,准确识别地名和组织名等实体可以提高搜索结果的相关性和精准度;知识图谱构建过程中,命名实体识别是构建实体关系的基础,可以从大量文本中抽取有价值的实体信息,丰富知识图谱的内容。

- 问答系统

- HuggingFace提供的问答系统相关的模型和工具函数,可以帮助用户快速地从大量文本中找到答案。在智能客服系统中应用广泛,企业的客服机器人可以利用这些技术回答用户常见问题,提高客户服务的效率和质量。同时,在在线教育平台,也可以构建基于问答系统的学习辅助工具,帮助学生快速找到学习资料中的重点内容和答案。

(二)多模态应用场景

- 跨媒体信息处理

- 在处理同时包含文本、图像、音频或视频等多种信息的复杂任务时发挥作用。例如在多媒体创作工作流中,可能需要根据图像内容生成相应的文本描述(如自动为图片添加标题或者描述),或者根据音频内容进行文本转录和分析,HuggingFace的多模态处理能力能够整合不同模态的信息进行综合处理,提高信息处理的效率和准确性。

- 智能交互界面

- 对于构建具有多模态交互能力的智能界面意义重大。例如智能车载系统,通过语音输入(音频)获取用户指令,结合车内摄像头(图像)识别驾驶员状态,并以语音和显示屏(图像和音频)展示相关信息和反馈,HuggingFace的多模态支持可以使这个交互过程更加智能和流畅,实现真正的人机多模态交互体验。

(三)低代码开发环境中的集成

在低代码开发平台中,HuggingFace可以方便地被集成。例如在ILLA Cloud平台中,可以连接到HuggingFace的API。开发者可以在平台中使用组件构建UI,然后通过配置HuggingFace资源,选择模型、设置参数等操作,快速实现用户输入内容并提交给HuggingFace的API,API返回生成内容并展示到前端。这大大降低了开发中对AI模型集成的难度,使得开发人员无需大量编写代码就能实现AI功能与前端交互的应用,加速了具有AI功能的应用开发进程。

四、如何使用HuggingFace

(一)环境搭建

- 安装Python和pip

- 首先确保您的计算机已经安装了Python(建议安装Python 3.8或更高版本),因为HuggingFace主要是基于Python开发的。同时需要确保Python的包管理器pip已经安装,pip用于后续安装HuggingFace相关的库。

- 安装HuggingFace库及其依赖项

- 通过终端或命令提示符运行pip命令来安装HuggingFace的核心库及其依赖项。例如,如果您想安装Hugging – Face的Transformers库,可以使用命令

pip install transformers。如果要获取完整功能,可能还需要安装相关的数据集库(如datasets)和分词器库(如tokenizers),同样可以使用pip进行安装,如pip install datasets tokenizers等相关命令。

- 通过终端或命令提示符运行pip命令来安装HuggingFace的核心库及其依赖项。例如,如果您想安装Hugging – Face的Transformers库,可以使用命令

- 配置虚拟环境(可选但推荐)

- 可以使用虚拟环境来隔离不同项目的依赖项,防止不同项目之间库的版本冲突。例如使用Python的虚拟环境工具

venv,创建一个虚拟环境后再在这个虚拟环境中安装HuggingFace库。使用python -m venv myenv(这里myenv是您自定义的虚拟环境名称)创建虚拟环境,然后通过激活虚拟环境(在不同操作系统下激活方式略有不同,例如在Windows下是myenv\Scripts\activate,在Linux下是source myenv/bin/activate),进入虚拟环境后再进行上述HuggingFace库的安装,这样项目之间的环境更加独立和清晰。

- 可以使用虚拟环境来隔离不同项目的依赖项,防止不同项目之间库的版本冲突。例如使用Python的虚拟环境工具

(二)模型的使用

- 加载预训练模型

- 首先根据您的需求选择合适的预训练模型。HuggingFace的Transformers库提供了很多预训练模型的选择,如BERT、GPT、RoBERTa等。例如,如果您想要使用BERT模型进行文本分类任务,可以通过如下代码加载预训练模型:

from transformers import BertModel

model = BertModel.from_pretrained('bert - base - uncased')这里

bert - base - uncased是模型的名称,不同的预训练模型有不同的名称标识,可以在HuggingFace的官方文档或者模型库中查询到对应的名称。 - 模型微调(可选)

- 如果预训练模型不能完全满足您特定的任务需求,您可以对其进行微调。这通常需要准备与任务相关的数据集,对数据进行预处理后,进行微调训练。例如对于文本分类任务,您可能需要调整模型的分类层以适应您的分类类别,然后利用自己的标记数据在预训练模型的基础上进行进一步的训练。

- 模型推理

- 在模型加载(并微调完成如果有必要的话)后,可以进行模型推理。例如对于一个文本分类模型,您可以将待分类的文本进行与训练时相同的预处理(如分词、添加位置编码等),然后将处理后的文本输入到模型中,得到模型对该文本的分类预测结果。一般来说,可以使用管道(pipeline)方法来简化推理流程,如:

from transformers import pipeline

classifier = pipeline('text - classification', model = model)

result = classifier('This is a sample text')

print(result)这里首先创建了一个文本分类管道,将之前加载(和微调后的)模型传入其中,然后输入一个示例文本

This is a sample text,最后得到并打印出模型的分类预测结果。

(三)在特定任务中的使用示例

- 以文本分类任务为例

- 数据准备:

- 使用HuggingFace的Datasets库下载合适的文本分类数据集,如IMDB电影评论数据集(可使用命令

datasets.load_dataset('imdb')进行下载)。然后查看数据集的结构,了解数据集的格式,例如数据集中包含哪些字段、文本内容的存储格式和对应的标签格式等。

- 使用HuggingFace的Datasets库下载合适的文本分类数据集,如IMDB电影评论数据集(可使用命令

- 数据预处理:

- 加载预训练的分词器(例如对于BERT模型,可以使用

from transformers import BertTokenizer; tokenizer = BertTokenizer.from_pretrained('bert - base - uncased')加载其对应的分词器),对文本进行分词、编码等操作,将文本转换成模型可以接受的输入形式。例如对IMDB数据集的评论数据进行分词和编码,将处理后的数据转换为PyTorch的DataLoader,以便于在模型训练过程中使用这些数据。

- 加载预训练的分词器(例如对于BERT模型,可以使用

- 模型训练和评估:

- 按照前面提到的方法加载预训练模型并配置训练参数(如设置优化器、学习率调度器等),然后使用PyTorch的训练循环对模型进行训练。训练完成后,可以使用测试集对模型在测试集上的表现进行评估,例如计算准确率、召回率、F1 – score等指标来量化模型的性能,根据评估结果对模型进行调整优化,如调整模型结构、调整超参数等,以提高模型的性能。

- 数据准备:

津公网安备12011002023007号

津公网安备12011002023007号